Neulich erst wollte ich eine Seite aus dem Google Index nehmen. Wie gewohnt habe ich im Google Webmaster Tools unter Google-Index -> URL entfernen die komplette Domain entfernt. Damit es zu keiner erneuten Indexierung seitens Google kommen kann, habe ich in der robots.txt folgenden Eintrag geändert:

User-agent: *

Disallow: /

Eigentlich dürften jetzt alle Bots / Crawler, welche die robots.txt befolgen, die Seite nicht mehr auslesen. Bei einem Test ist mir aber aufgefallen, dass der Google AdsBot die robots.txt einfach ignoriert.

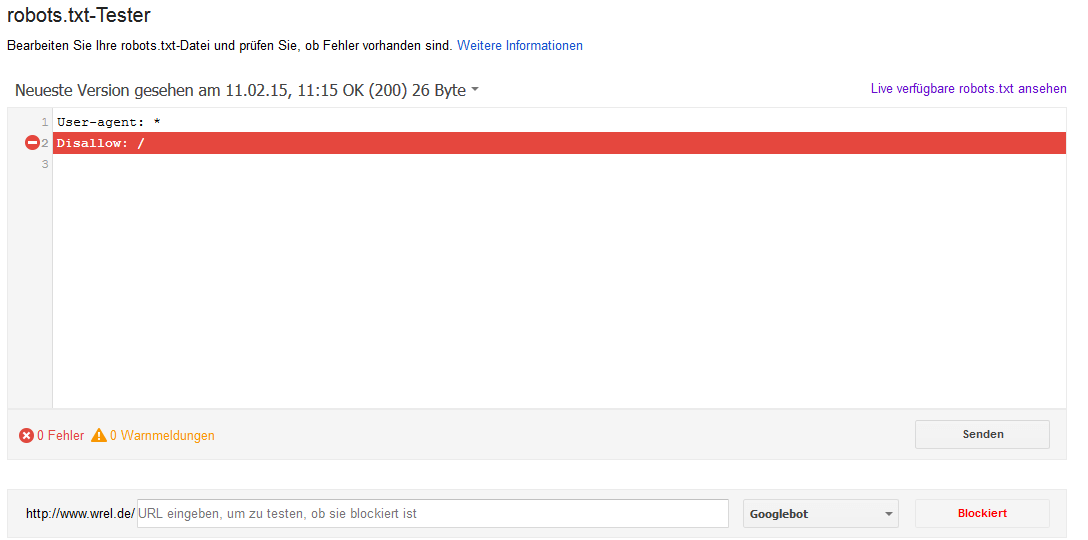

Robots.txt-Tester in den Webmaster Tools

Bei Änderungen in der robots.txt ist es immer hilfreich, diese mit dem in Google Webmaster Tool befindlichen robots.txt-Tester zu überprüfen. Hier kann mit diversen Google-Bots das Crawling-Verhalten an verschiedenen URLs getestet werden.

Eigentlich reicht dieser Test schon aus, um mir zu zeigen, dass der Google-Bot meine Seite mit dieser Einstellung nicht crawlen wird.

Verhalten des Google AdBots

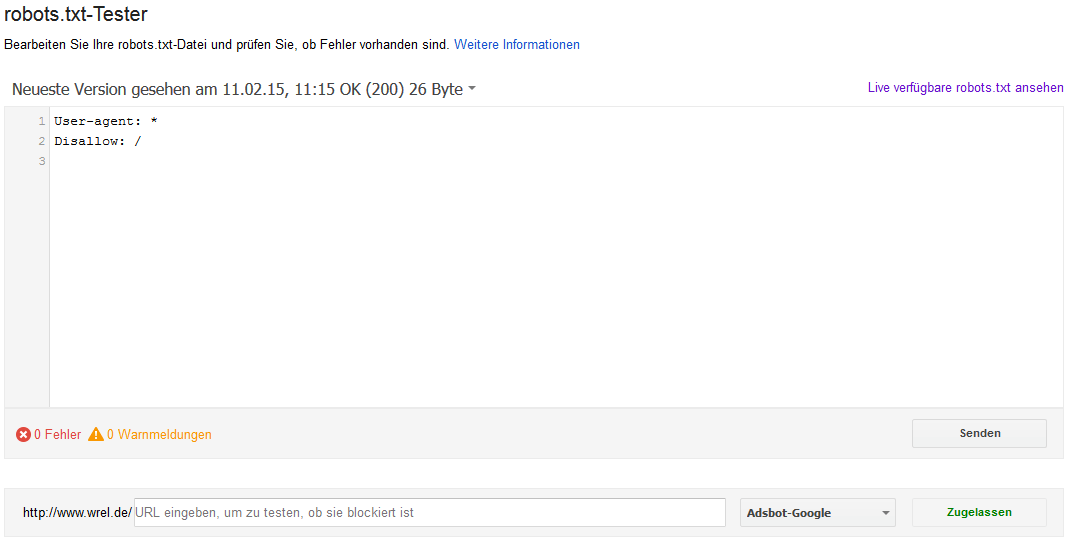

Rechts unten im robots.txt-Tester können verschiedene Google-Bots getestet werden. Einschließlich des Google AdsBots. Mit meiner zweizeiligen robots.txt müsste mit der Wildcard für den User-Agent jeder Bot, der die robots.txt-Anweisungen befolgt, eigentlich meine Seite nicht crawlen. Nicht so der Google AdsBot:

Der Bot ignoriert einfach die robots.txt, welche auch diesen ausschließen müsste.

Was ist der Google AdsBot?

Der Google AdsBot besucht eure Seite dann, wenn diese als Landingpage in einer Adwords Kampagne angegeben wird. Dieser Bot prüft verschiedene Kriterien von eurer Zielseite: Qualitätsfaktor, Ladezeit, entspricht die Seite den Google Richtlinien etc….

Warum wird die robots.txt ignoriert? (Antwort von Google)

Nachdem ich diesen Beitrag auch bei Google+ geteilt habe, bekam ich direkt Antwort von John Mueller (Google Zürich). Er hat mich auf eine passende Google Support Seite verwiesen, wo zu lesen ist:

Um zu vermeiden, dass Qualitätsfaktoren und Anzeigenrang abnehmen und CPCs für Werbetreibende steigen, die AdWords-Besuche ihrer Seiten nicht einschränken möchten, ignoriert das System pauschale Ausschlüsse und Platzhalter ( z. B. User-Agent: * ) in robots.txt -Dateien.

Quelle: Google Support – Unteren Reiter ausklappen

Wie kann ich den Google AdsBot trotzdem ausschließen?

Damit der Google AdsBot nicht mehr auf die Seite zugreifen kann, muss in der robots.txt der User-Agent des Crawlers angegeben werden:

User-agent: *

Disallow: /User-agent: AdsBot-Google

Disallow: /

Mit diesen zusätzlichen zwei Zeilen kommt auch der Google AdsBot laut robots.txt-Tester nicht mehr auf die Seite.